“Super-Turing AI” es una propuesta para reducir el consumo energético en IA Copiar al portapapeles

POR: Luis Moctezuma

26 marzo, 2025

La Inteligencia Artificial (IA) está cada vez más presente en nuestra vida cotidiana. Uno de los grandes problemas que trae consigo el uso de esta tecnología es el consumo de recursos.

Un grupo de ingenieros de la Universidad Texas A&M propone un sistema inspirado en el cerebro humano para ahorrar recursos. Los resultados se publicaron recientemente en la revista Science Advances.

El consumo energético de la IA

Tomemos como ejemplo a Chat GPT de Open AI, uno de los servicios de conversación más populares basados en Inteligencia Artificial. Para entrenar a su versión 3 fueron necesarios 78,437 kilovatios por hora, de acuerdo con Portaltic.

Como referencia, de acuerdo con Datosmacro de Expansión, en 2023 cada mexicano consumió en promedio 2,559.3 kilovatios por hora. Esto significa que el entrenamiento del popular servicio de conversación requirió el equivalente a 30.6 veces lo que un ciudadano mexicano promedio consume en un año.

Los sistemas basados en Inteligencia Artificial pueden realizar cálculos complejos y analizar datos mucho más rápido que cualquier ser humano. Sin embargo, el cerebro humano tiene una gran capacidad de cómputo con un consumo mínimo de energía.

“Estos centros de datos consumen energía en gigavatios, mientras que nuestro cerebro consume 20 vatios”, explicó al medio digital TechXplore Suin Yi del Departamento de Ingeniería Eléctrica y Computacional de la Universidad Texas A&M.

La referencia que ofrece el investigador nos deja con una clara diferencia. Mientras la IA consume miles de millones de vatios, nuestro cerebro necesita apenas un par de decenas.

Los métodos computacionales actuales no permiten un consumo de energía sustentable por parte de los centros de datos. Suin Yi resalta que siguen siendo necesarios el hardware y la generación de energía para mantener estos sistemas.

La demanda de energía de estos sistemas va más allá de los costos operacionales para los desarrolladores. También trae consigo problemas ambientales derivados de la huella de carbono a gran escala asociada con los centros de datos.

En este sentido, el consumo energético no es el único problema para el medio ambiente. Los servidores que almacenan los sistemas de IA recurren a sistemas de refrigeración. Un estudio publicado en enero en el repositorio arXiv.org estima que para el entrenamiento de Chat GPT-3 se realizó un consumo directo de 700,000 litros de agua dulce limpia.

Para dimensionar este consumo de agua podemos recurrir nuevamente al uso doméstico. De acuerdo con ONU-Habitat.org, el consumo diario de agua por persona en México es de 366 litros. Lo que significa que el entrenamiento de la versión anterior de Chat GPT consumió lo mismo que un mexicano en 1,912.6 días (aproximadamente 5.2 años).

Una solución de bajo consumo

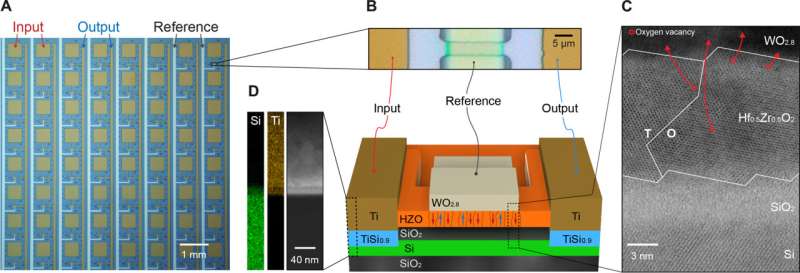

“Super-Turing AI” imita el funcionamiento del cerebro humano. Este sistema integra algunos procesos, en vez de separarlos, y posteriormente migra grandes cantidades de datos como lo hacen los sistemas actuales.

El nombre del sistema es en honor a Alan Turing. Este matemático de mediados del siglo XX realizó trabajo teórico de gran importancia para el desarrollo de la computación, la Inteligencia Artificial y la criptografía.

Mientras que en el cerebro humano el aprendizaje y la memoria se encuentran integrados, los sistemas computacionales basados en IA guardan por separado los datos y los procesos del entrenamiento.

“Los modelos tradicionales de IA dependen en gran medida de la retropropagación, un método utilizado para ajustar las redes neuronales durante el entrenamiento… Si bien es eficaz, la retropropagación no es biológicamente plausible y es computacionalmente intensiva”, explica Suin Yi.

El investigador menciona que su trabajo resuelve las improbabilidades presentes en los algoritmos de aprendizaje. “Nuestro equipo explora mecanismos como el aprendizaje Hebbiano y los procesos de plasticidad dependientes del tiempo de pico que ayudan a las neuronas a fortalecer las conexiones de una manera que imita cómo aprenden los cerebros reales”, describe.

Para comprobar sus sistema se hicieron pruebas con un dron. El dispositivo voló para aprender y adaptarse. El resultado fue un proceso más rápido, eficiente y con menor consumo energético que la IA tradicional.